Personal computer

“S-a-l-v-e p-r-o-f-e-s-s-o-r F-a-l-k-e-n”. La voce, metallica e monocorde, si diffonde nella stanza da un piccolo altoparlante dalle forme talmente retrò che oggi si potrebbe trovarlo facilmente in un negozio di design. Alla scrivania, un giovanissimo Matthew Broderick guarda preoccupato l’oggetto che ha davanti e comincia a digitare su una tastiera. Nessun codice particolare, solo parole del linguaggio comune con cui il piccolo genio dell’informatica dialoga con il potente mainframe del Pentagono, cercando di dissuaderlo dal proseguire un “gioco” cominciato qualche sera prima che risponde all’inquietante nome di “Guerra termonucleare globale”. Il punto è che il computer, da brava macchina, ha preso molto seriamente la cosa, portando effettivamente il mondo sulla soglia di un vero conflitto. È il 1983, e la scena che abbiamo descritto è una di quelle del film WarGames. Se abbiamo deciso di aprire questo articolo evocandola, non è perché negli anni Ottanta prospettare che un computer intervenisse sulla realtà, pilotasse dei missili o si connettesse a un altro calcolatore fosse inimmaginabile come il Nautilus ai tempi di Verne. Già allora l’immaginario informatico era ben sviluppato grazie a film come Guerre stellari (1977), con le sue astronavi e i suo androidi, Star Trek (1979), in cui per avere accesso al computer bastava chiamarlo e parlarci, nonché 2001 Odissea nello spazio (1968), dominato da quello psicopatico di HAL 9000. Il punto è che fino a WarGames mancava il legame con la realtà, ovvero l’idea che la macchina che rendeva possibili simili meraviglie si potesse trovare nella stanza di un ragazzetto del liceo.

Prima di allora l’informatica era stata tutt’altro. I computer erano strumenti per effettuare calcoli complessi, ordinare grandi moli di dati e, in ogni caso, per lavorare. Quando giocavano a scacchi, bastava un mediocre giocatore per metterli in difficoltà. Altro che battere il campione del mondo come avvenne invece nel 1997. E poi erano grandi: un mainframe poteva occupare diversi ambienti mentre un minicomputer, a dispetto del nome, era grande quanto un armadio. Per arrivare a qualcosa di simile agli attuali elaboratori, bisognava pensare in termini di microcomputer, mentre un oggetto come l’iPad era decisamente fuori da qualunque reale orizzonte tecnologico (almeno fino ai primi anni Novanta quando Apple sviluppò Newton, il nonno dell’attuale tablet computer). Ma quel che più conta è che i calcolatori elettronici (oggi ci sono rimasti solo gli ingegneri a chiamarli così) non erano mai utilizzati da una sola persona. E non perché sulla stessa tastiera si alternassero più individui, ma perché ogni postazione era in realtà un terminale che passava informazioni al cervellone principale senza essere in grado di elaborarle in alcun modo. L’idea era che, vista la rapidità di esecuzione della macchina rispetto all’uomo, nel tempo che questi impiegava a formulare le sue domande, il calcolatore avrebbe potuto dar retta ad altri operatori. L’esatto opposto di quanto avviene oggi, in cui i processori dei computer commerciali sono multi core, ovvero hanno al loro interno più nuclei di elaborazione per poter rispondere velocemente alle richieste dell’utente. Un dato che, detto così, potrebbe far nascere il dubbio che in questi anni anche i neuroni nel nostro cervello siano aumentati. Niente di tutto questo, naturalmente, nessuna necessità di rimettere mano a Darwin, semplicemente ciò che è cambiato è la natura delle domande che facciamo al computer, ma soprattutto il modo di farle, grazie a sistemi operativi sempre più in grado di mediare tra noi e la bruta potenza di calcolo.

Nel 1980 l’informatica era questo: un monitor a fosfori verdi e una tastiera con la quale scrivere lunghe righe di codice. Sì, perché a quell’epoca non c’era solo un’altra idea di computer, ma anche un’altra idea di software. Office, Autocad, Photoshop e tutti gli altri cosiddetti applicativi non esistevano. A dirla tutta non esistevano neanche i sistemi operativi, ovvero quei software che oggi gestiscono tutte le graziose icone che vediamo sul monitor quando accendiamo il computer. Chi voleva far funzionare un computer, inserire dei dati al suo interno e chiedergli di analizzarli, doveva scriversi i programmi da sé. Fu allora che nacque l’equivalenza esperto di computer = programmatore che è poi rimasta a lungo nel linguaggio comune. Avere accesso all’informatica in queste condizioni era proibitivo, e infatti rimaneva confinata nei grandi uffici (banche, compagnie aeree) e nei laboratori di ricerca, ecosistemi entrambi ricchi di esperti sistemisti e geni visionari. Come nel leggendario PARC di Xerox in cui, decenni prima della loro comparsa nel mercato, furono sviluppate tecnologie ancor oggi fondamentali tra cui il mouse e l’interfaccia grafica. Uniche incursioni fuori da questi sancta sanctorum, la scienza informatica se le concedeva in direzione di qualche garage, come ad esempio quello di Steve Jobs che leggenda vuole abbia visto la nascita del prototipo di quello che da molti è considerato il primo personal computer: l’Apple II costruito insieme a Steve Wozniak (a onor del vero c’erano stati già altri tentativi in questa direzione – lo Xerox Alto del 1972 e lo Sphere 1 del 1975 – ma per funzionalità, aspetto e modalità di commercializzazione il modello di Apple fu senz’altro il primo della sua specie). Ripensare il computer in termini “personal”, non significava soltanto immaginare che sulla scrivania di ognuno potesse esserci una macchina totalmente autosufficiente, né che fosse possibile utilizzarla senza l’intervento di squadre di programmatori; voleva dire soprattutto (ma questo lo si capì bene solo dopo) che quell’oggetto aveva a che fare con particolari emozioni e relazioni, come l’etimologia della parola suggerisce.

Nel frattempo l’era del computer personale era cominciata e gli annunci di nuove tecnologie cominciarono a susseguirsi con rapidità. Primo fra tutti quello della più importante industria del settore informatico, l’IBM, che nel 1981 presentò lo storico modello 5150, in seguito conosciuto come il primo IBM PC. Da questo computer la concorrenza cominciò a produrre i cosiddetti PC-compatibili, copie ottenute imitando i circuiti originariamente sviluppati dal colosso industriale che, pertanto, condividevano con il capostipite la medesima architettura. La compatibilità era dunque legata alla possibilità di utilizzare il medesimo software, e, in ultima analisi, fu questa la ragione del successo del PC. Bill Gates, con la sua Microsoft, si era infatti previgentemente premurato di non cedere l’esclusiva dei diritti del sistema operativo che aveva sviluppato alla IBM, riservandosi la possibilità di venderlo anche a tutti gli altri concorrenti, creando una base comune a cui gli sviluppatori di applicativi si sarebbero dovuti adeguare (la stessa Microsoft, naturalmente, che stava sviluppando Word ed Excel, usciti rispettivamente nel 1982 e 1985, ma anche la Autodesk che, nel 1982, aveva sviluppato un importante software per il disegno tecnico chiamato Autocad). Ed ecco il punto: il software diventava più importante dell’hardware. Vendere algoritmi e parole scritte nello strano linguaggio dell’informatica, consentiva di realizzare profitti molto superiori a quelli di chi realizzava pezzi di metallo e silicio. Inoltre, dato che richiedeva bassissimi capitali per cominciare a produrre, questa forma di industria si presentava come la più accessibile di tutti i tempi. Trent’anni dopo, Google, Microsoft, Yahoo!, YouTube, Facebook e Apple sono tra le più importanti aziende a livello mondiale.

Sebbene l’informatica personale fosse a questo punto possibile, non era ancora una tendenza in atto. Come accade spesso quando una nuova tecnologia si affaccia sul mercato, il vantaggio che essa offre viene percepito dai più in maniera parziale o incompleta. L’automobile a lungo era stata considerata dai più una rumorosa e inaffidabile alternativa al cavallo, così come ora il computer si presentava come un complicato sostituto di macchine da scrivere, calcolatrici, righe, squadrette etc. Per allargare il mercato si poteva o accettare la sfida, dimostrando l’utilità del computer, oppure, come si fece, aggirare l’ostacolo, cambiando del tutto il sistema di valori. Il VIC-20 della Commodore, primo vero computer di successo, capace, nel 1980, di vendere milioni di esemplari, fu una macchina che non nascondeva una spiccata tendenza al gioco (“A real computer for the price of a toy”, diceva lo slogan). Addirittura il suo successore, il 64, sembra detenga ancora oggi, con i suoi 17 milioni di pezzi venduti, il titolo di maggior successo commerciale di tutti i tempi. Altra caratteristica chiave dei modelli Commodore fu la loro forma fisica: tutti i componenti necessari al funzionamento erano infatti contenuti dentro quella che si presentava come una spessa tastiera. Si tratta di un particolare per noi interessante perché, con tutta evidenza, allora la miniaturizzazione era sentita come una esigenza perfino più pressante di quanto non lo sia oggi. Il computer faceva di tutto per non disturbare, per mimetizzarsi in salotto dialogando con un oggetto ben noto come il televisore, già da tempo vero focolare di ogni ambiente domestico che adesso trovava stravolto il suo ruolo. Ci sarebbero voluti anni perché si affermasse il diritto del calcolatore ad avere una scrivania tutta sua o, come accade oggi, a prendere il posto della TV. Niente di insolito in questo: quando ancora la telefonia mobile era in corso di sviluppo, i produttori si affannavano a realizzare modelli sempre più piccoli, finché, giunti a livelli di miniaturizzazione da agenti segreti, la conversazione telefonica non è diventata la funzione meno richiesta e, di colpo, non c’è stato più alcun problema a far entrare nelle tasche ingombranti smartphone.

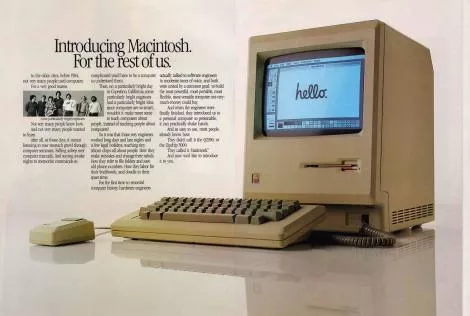

L’ultima vera rivoluzione degli anni ottanta, che segna il completamento di quella concezione personal dell’informatica che arriverà grosso modo intatta fino a tempi recentissimi, si ha nel 1984 con il lancio del Macintosh di Apple. Mac, come si è subito preso a chiamarlo contrapponendolo al PC, non era come gli altri e lo si vide subito durante la presentazione che un famoso spot televisivo diretto da Ridley Scott aveva preannunciato. Steve Jobs sale sul palco, saluta la folla e annuncia che presenterà Macintosh “in persona”. A questo punto solleva una borsa bianca, posa il contenuto su un banchetto, inserisce un floppy e va via, lasciando la parola a lui, il primo computer ad avere un nome che non sia una sigla con dei numeri. Un “soggetto” che è in grado di parlare, leggere, scrivere, far di conto, ma anche manipolare fotografie, realizzare disegni architettonici tridimensionali, suonare musica, funzioni allora inimmaginabili per una macchina che integrava in un solo corpo monitor, componenti e floppy (uno dei primi da 3,5 pollici). Ma le novità che non potevano non colpire erano due: mouse e icone. Ovvero, la possibilità di attivare programmi e di manipolare informazioni senza dover scrivere lunghe righe di testo, semplicemente premendo un bottone su quella che era una metafora della scrivania che ognuno riconosceva (cestino compreso). Quello che accadde in seguito ha ben poco di rivoluzionario. Nel 1985, Microsoft cerca di colmare il gap tecnologico presentando Windows, più che un vero sistema operativo una interfaccia grafica per il solito DOS. Ci vorranno altri dieci anni perché Windows 95 traghetti finalmente Microsoft verso la visualità. A quel punto però le novità non sono più i computer o i sistemi operativi, da quel punto di vista è tutto un inseguirsi di tecnologie e versioni, la vera svolta è data da Internet.

È il World Wide Web a cambiare ogni cosa. Il concetto di rete che caratterizzava l’informatica distribuita ritorna riveduto e corretto secondo una scala che ne trasforma profondamente la natura. È un universo ancora senza regole, di cui nessuno può ancora ipotizzare l’estensione, un west selvaggio in cui tutto può accadere. Una curiosità: il primo Web server di tutti i tempi viene realizzato nel 1990 su una workstation NeXT, la compagnia che Steve Jobs aveva fondato quando il consiglio di amministrazione della Apple lo aveva allontanato dall’azienda . Come in ogni far west che si rispetti, anche in questo si verifica una corsa all’oro, quello di un mercato senza confini che non tarderà troppo a mostrare la sua natura illusoria con l’esplosione della bolla speculativa delle cosiddette dotcom. Internet è un giocattolo pericoloso, un pianeta in cui le più elementari leggi della fisica commerciale e sociale non valgono, spinto com’è da moltiplicatori inauditi. Tra i primi a capirlo sono le case discografiche, quando si trovano davanti i ritmi di crescita del primo Napster, il software per la condivisione di brani musicali che in pochi mesi di attività mette in ginocchio l’intera industria. Il Web non allarga il mercato come sperato, ne crea uno nuovo, che funziona con regole e prodotti nuovi. Gli antivirus, per esempio, che vengono alla luce in seguito alla geniale invenzione dei virus, minuscoli software il cui scopo non è tanto produrre danni alla macchina che li ospita bensì fare pubblicità a chi li ha realizzati. Brain, il primo virus della storia (1986) riporta addirittura indirizzo e numero di telefono dei due fratelli pakistani che lo avevano scritto che, evidentemente, pensavano già a un impiego nel mondo della sicurezza o al business degli antidoti.

Attenzione però, sarebbe ingenuo ritenere che a muovere le persone siano sempre gli stessi valori. Finché si agisce all’interno di una sfera locale più o meno ampia, è facile prevedere quale possa essere il ritorno che ci aspettiamo per una fatica come quella di programmare un software, ma quando la nostra vita si sposta dal mondo reale a quello virtuale cosa accade? Si può spiegare solo in questo modo il fenomeno del software Open Source che esplode tra la fine degli anni Novanta e il nuovo millennio. Si tratta, per così dire, del primo prodotto che nasce interamente dentro quella forma di vita che è la rete, il primo soggetto nato sul nuovo pianeta. Di cosa si tratti è presto detto: software gratuito il cui codice (source) viene lasciato appunto “aperto” (open) ovvero leggibile e modificabile da chiunque in modo da rendere possibile miglioramenti e personalizzazioni di ogni tipo. Campione di questa nuova specie è Linux, il sistema operativo “alternativo” che pian piano comincia a mangiare le quote di mercato ai concorrenti commerciali. Non è solo il denaro a muovere la gente, l’identità prende nuove forme, e anche quando è questo l’obiettivo finale, i modi per raggiungerlo sono molto diversi. L’Open Source, in altre parole, è open solo sulla carta, perché il gruppo di quelli che effettivamente incidono sull’evoluzione di un software è tutt’altro che accessibile. Si tratta di vere e proprie comunità esclusive, in cui non conta quanti soldi hai, o che macchina guidi, ma cosa sai fare e quanto lontano va la tua visione. Quando nel 2004 Mark Zuckerberg realizza Facebook si guarda a lungo dal vendere spazi pubblicitari, lascia prima che i contatti crescano e le funzionalità si sviluppino, e così, quando fa il grande passo, quello che propone è l’insieme di consumatori meglio strutturato della storia. Alla fine, il virtuale ritorna alla realtà del portafoglio, così come ogni chat finisce con una pizza, il punto è che il modo in cui questo accade ha delle conseguenze.

E poi ecco l’iPad, l’ultima grande rivoluzione del mercato informatico. Il punto non è la miniaturizzazione, idea tutt’altro che innovativa come abbiamo visto, bensì le modalità di interazione. Lo schermo sensibile al tocco se da un lato è l’uovo di Colombo che consente di risparmiare lo spazio della tastiera, dall’altro rende possibili relazioni con l’ambiente operativo e con il software del tutto nuove. Maneggiare una fotografia, attivare un programma, giocare a un videogame diventano una esperienza diversa perché diverso è il modo in cui coinvolgono le molteplici dimensioni della nostra soggettività, quella cognitiva, ma anche quella corporale, sensibile. Ed ecco ottantenni che sfogliano disinvolte album fotografici e navigano siti, le stesse persone che con il mouse avevano enormi difficoltà a misurare il gesto (vedere per credere su YouTube). Personal allora non è più un calcolatore usato soltanto da una persona, né un oggetto a cui siamo legati da relazioni tanto forti da considerarlo indispensabile, è sempre più evidente che è l’attore sociale nel suo complesso a essere cambiato. Non è più soltanto un uomo, è ormai un uomo-con-il-computer, un ibrido di cui sappiamo poco, tranne il fatto che farà e vorrà cose diverse da quelle che un semplice umano fa e vuole. Personal, dunque,non è più attributo di computer, è vero piuttosto il contrario, è computer a essere attributo di una personalità che sempre più eccede i confini di un corpo fisico, dando vita a un corpo sociale del quale fanno parte, senza possibilità di distinzione, umani e non-umani.

Non resta allora che rispondere: “S-a-l-v-e J-o-s-h-u-a”.