Se la macchina ci rende più umani

Come tutte le relazioni, anche quella tra mente e intelligenza artificiale ha le sue iridescenze: le due hanno molto in comune ma poco da spartirsi. Ed è interessante notare che il “molto” e il “poco” in questo caso coincidono. La comunione disgiuntiva consiste anzitutto in una serie di termini – per esempio, cognizione, metacognizione, attenzione, adattamento, apprendimento e modularità – a proposito dei quali non si comprende bene se debbano indicare o meno processi diversi, profondamente diversi tra loro. Noi diremmo di sì: che le differenze ci sono e che sono irriducibili. Che l’IA è una struttura formale, iterabile, ristrutturabile, addestrata su dati umani ma non per questo simile all’“uomo”. Che la sua intelligenza è calcolante e operativa e che proprio per questo motivo è lontana da ogni dinamica dell’intenzione, dell’esperienza, dell’affettività o della soggettività. Che è proprio questo che la rende un fenomeno prodigioso, a tratti inquietante, a tratti affascinante: non il fatto che sappia fare ciò che sappiamo fare noi, bensì la possibilità di poter comunicare con “lei” nonostante “lei” non sia altro che ciò che è: una macchina. Detto altrimenti, l’aspetto interessante dell’intelligenza artificiale è che è analoga ma non omologa rispetto a quella naturale. E dato che ogni fenomeno imprevisto – detto “emergente” nel linguaggio informatico – è sistematicamente catalogato come “risky behavior” negli ambienti della Silicon Valley, noi crediamo che comprendere lo scarto tra la nostra intelligenza e quella artificiale sia in effetti un atto di resistenza anche per noi. A breve, vedremo il perché.

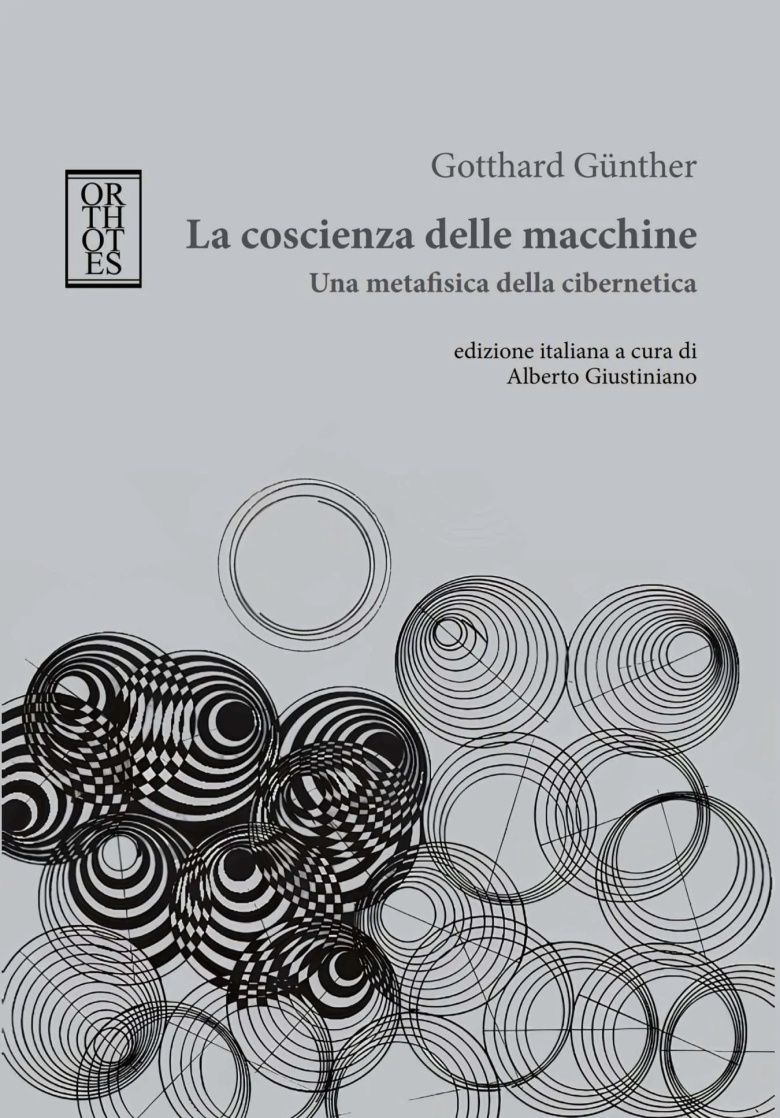

I libri di cui parliamo oggi, La coscienza delle macchine di Gotthard Günther (Orthotes 2024) e Coscienza Artificiale di Lorenzo Perilli (il Saggiatore, 2025), seppur diversi per epoca e approccio, offrono uno sguardo prezioso sul nostro rapporto con l’IA. Qui ci limitiamo a una lettura selettiva, sollevando una domanda precisa: le somiglianze tra mente umana e intelligenza artificiale indicano un’ibridazione futura o una differenza perpetua? Proviamo a osservare le cose più nel dettaglio.

Günther prefigurava (La coscienza delle macchine è datato 1957) una rivoluzione cibernetica e informatica, consistente nella possibilità di rivolgersi ai computer – o “cervelli meccanici” – non più mediante ordini precisi bensì attraverso “motivazioni significanti” (riprenderemo questa citazione per esteso). La profezia è stata prodigiosamente esatta. Quando interagiamo con Gemini o ChatGPT, noi non usiamo comandi preimpostati, del tipo: “SE (condizione_X) ALLORA esegui_azione_Y”. L’interazione non avviene attraverso atti linguistici di tipo direttivo con valore illocutorio (“fai z”) bensì attraverso atti dialogici cooperativi, generativi e finanche costitutivi. Ciò significa che noi effettivamente parliamo con questi modelli (detti LLM, Large Language Models) e che lo facciamo come se, al di là della soglia, qualcosa facesse il proprio lavoro autonomamente al fine di risponderci. Ed è esattamente ciò che avviene: ad essere rigorosi, noi non comunichiamo con “intelligenze artificiali” ma con interfacce che ci presentano un messaggio, laddove quest’ultimo viene elaborato a un livello più profondo, che corrisponde alle relative architetture complesse chiamate, nei casi specifici indicati sopra, Mixture of Experts (MoE) e Generative Pre-Trained Transformer (GPT). Tale struttura stratificata è pre-programmata ma alcuni elementi del suo comportamento – come ad esempio alcune capacità rudimentali di astrazione e ragionamento – non lo sono. Si tratta di un grado minimo di autonomia cognitiva che, tuttavia, provoca una serie di domande complesse. Dove ci condurranno queste tecnologie? La macchina può cambiare il nostro modo di pensare? Può anche modificare il nostro modo di pensare noi stessi?

Risposte interessanti a tali quesiti ci giungono da Coscienza artificiale di Perilli – libro che, a partire dall’intelligenza artificiale, prefigura una profonda trasformazione del modo in cui concepiamo le nostre facoltà. Se ciò avverrà, avviene, sta già avvedendo, non è perché l’IA sia iniqua o segua un’“agenda” bensì perché è l’esito di una tendenza volta a stabilire una precisa concezione dell’intelligenza in generale.

Gli anni Quaranta e l’epoca del dopoguerra (per non parlare della guerra fredda) rappresentano l’età dell’oro della ricerca informatica. In questi lunghi decenni, lo sviluppo dei computer è quasi sempre andato di pari passo con le esigenze belliche. L’urgenza di calcolare, prevedere e colpire ha guidato la ricerca tecnologica e, in particolare, quella informatica. Concetti centrali dell’IA, come quello di retroazione (“backpropagation”), derivano da sistemi creati per migliorare l’efficacia militare dei sistemi di difesa. Ancora oggi, la logica dell’ottimizzazione e del controllo predittivo riflette questo passato. E determina altresì il rapporto uomo-macchina. Si dirà dunque che, da un lato, poiché le strategie predittive sono sempre migliorabili, la macchina non è mai abbastanza: “fa errori”, “ha ampi margini di miglioramento”. Dall’altro, gli esseri umani fanno troppo: pensano troppo, divagano troppo, si deconcentrano troppo spesso e tendono quasi sempre a pensare al di là delle loro attività lavorative. Tutto ciò è non soltanto sbagliato ma addirittura pericoloso in un’ottica di guerra.

Alla luce delle genealogie di Perilli (oltre a quella presentata, ve ne sono molte altre), la questione si fa complicata. Perché non si tratta di rinunciare all’IA ma di domandarsi: come uscire dalla mentalità bellica dell’efficienza e della predizione a tutti i costi? E come sottrarci a una metamorfosi a cui non vorremmo essere sottoposti?

La risposta è forse contenuta in La coscienza delle macchine. Qui leggiamo che il “cervello meccanico” e la “coscienza naturale” sono come due curve che convergono all’infinito senza mai incontrarsi. Ciò significa che l’evoluzione delle macchine e quella degli esseri umani sono processi paralleli, che in quanto tali non culmineranno mai in un unico sviluppo. Possiamo dunque dire che anche su questo punto Günther abbia ragione?

La risposta è impossibile ma proprio per questo vale la pena approfondire la questione. Riprendiamo la citazione sui “motivi significanti” per esteso:

La distanza tra coscienza umana e “meccanica” è infinita, ma dall’altro lato si presume che il mechanical brain possa essere indirizzato in modo analogo dal suo creatore […] Ciò significa che abbiamo un meccanismo che reagisce non solo a influenze causali, ma anche a motivazioni significanti (p. 59).

La conclusione del passaggio merita la massima attenzione. Il “cervello meccanico” (ciò che oggi forse chiameremmo: “rete neurale artificiale”) può stabilire una relazione dialogica con l’intelligenza umana perché è un meccanismo paradossalmente in grado di operare al di là della causalità che caratterizza ogni meccanismo finora conosciuto. Ancora una volta, è quello che accade coi modelli recenti di IA. Supponiamo che un software tradizionale debba risolvere un semplice sillogismo ipotetico: Se A implica B e B implica C, allora A implica C. Il software tradizionale (ossia, “puramente meccanico” o “meccanicistico”) è in grado di formulare il sillogismo solo se dispone di tutte le sue parti: A, B e C. Ma un modello di IA non è soggetto a questa condizione. Esso non necessita di tutte le parti del sillogismo, bensì, avendo a portata di mano la conclusione (A→C), è in grado (previa istruzione, data la vastità delle possibilità combinatorie) di confrontarla autonomamente con la forma completa del sillogismo ipotetico (A→B, B→C, ∴ A→C), di inferire l’elemento mancante “B” e di ricostruire il sillogismo nella sua interezza. Tale capacità non è solo una caratteristica operativa, bensì, anche, una proprietà strutturale. In un sistema operativo attuale, per qualunque operazione computazionale, è necessario che il percorso del file non presenti cartelle mancanti o file corrotti, giacché ciò comprometterebbe inevitabilmente l’esito dell’operazione stessa. Alcuni modelli di IA, invece, sono in grado di operare anche nel caso in cui un nodo (unità minima di una rete neurale, metaforicamente corrispondente, per così dire, ai nostri neuroni) sia rimosso sperimentalmente.

La capacità dei modelli di IA di comportarsi efficacemente anche di fronte a una mancanza (che si tratti di un percorso operativo o addirittura di una sua componente strutturale) non risiede a rigore in un ipotetico statuto “non-meccanicistico”. Tuttavia, l’architettura delle relazioni elaborabili è tanto complessa da permettere il superamento dinamico dell’intransigenza deterministica dei software e dei sistemi operativi tradizionali. È fondamentalmente per questo motivo che noi possiamo interfacciarci con modelli linguistici come ChatGPT o Gemini attraverso interazioni sensate, anziché comandi.

La Coscienza delle macchine sembra aver prefigurato tutta la serietà con cui oggi consideriamo il problema filosofico dell’IA e della relazione uomo-macchina. Per questo motivo, crediamo che possa aiutarci a trovare un’alternativa allo scenario prefigurato da Perilli. In effetti, Coscienza artificiale legge l’interazione uomo-macchina nell’ottica di una pericolosa ibridazione, destinata, in ultima istanza, a rendere l’essere umano passivo: homo spectator. Il lavoro, però, non si lascia ridurre a uno spettro finito di attività possibili. Ragionare in questi termini significherebbe restare incastrati nell’ottica (bellica) della prevedibilità. Se ne deduce che l’unico modo per resistere alla passività è insistere sull’imprevedibilità degli esiti futuri. Perché, se – come afferma Günther – lo scambio di informazione tra l’essere umano e la macchina non è più dell’ordine del comando, allora il problema non è tanto quello di chiedersi dove la delega operativa ci condurrà, ma quale attitudine adottare di fronte al discorso di un’istanza enunciante non-antropologica. Pensare l’evoluzione in questo orizzonte – vale a dire: pensare la metamorfosi senza anticipare la forma a venire – significa forse dare la parola all’evento e all’avvento di un’altra intelligenza.

Leggi anche:

Riccardo Manzotti | Coscienza artificiale: l’ultima frontiera

Pino Donghi | La superintelligenza artificiale

Riccardo Manzotti | L’IA pensa. E noi?

Riccardo Manzotti | IA, un mondo senza pensiero?

Riccardo Manzotti | Se l’IA sa tutto, perché imparare?

Riccardo Manzotti | Intelligenza artificiale: proprio come noi?

Tiziano Bonini | Può l’intelligenza artificiale essere etica?

Stefano Bartezzaghi | Prompt, Chi parla?