La sovranità editoriale delle AI

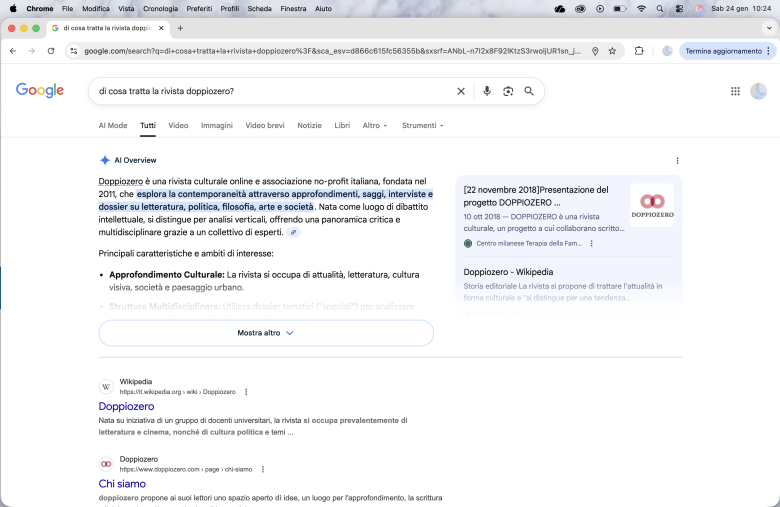

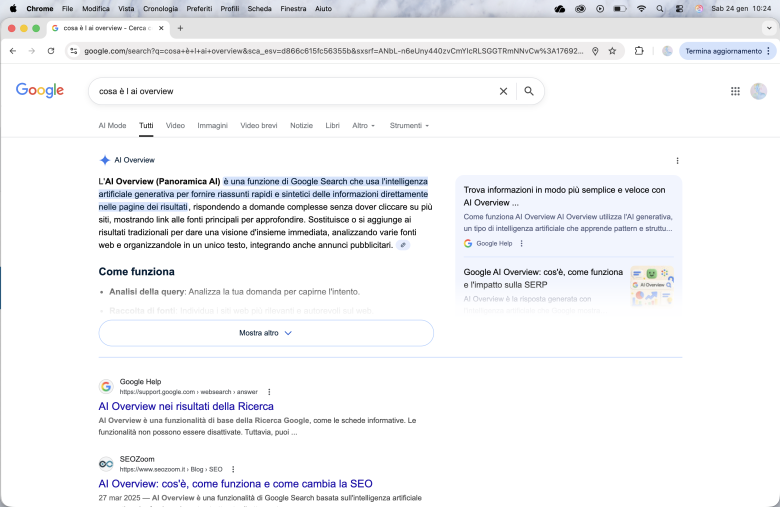

Il panorama digitale statunitense sta subendo una mutazione sistemica, che rischia di mettere fortemente in crisi l’ecosistema dell’informazione, così come lo abbiamo conosciuto, un fenomeno di cannibalizzazione algoritmica, che avviene sotto gli occhi di tutti e che pochissimi riescono a decodificare nella sua reale ferocia. Al centro di questa tempesta si colloca l'introduzione delle AI Overviews nei risultati di ricerca, una mossa con cui Google ha smesso di essere un semplice intermediario, un vigile urbano che smista il traffico verso le fonti, per trasformarsi in una destinazione finale, un corpo che assorbe la materia prima altrui (le informazioni dei giornali, i dati personali degli utenti, le immagini caricate in rete e sui social, etc.) per produrre una sintesi sintetica che trattiene l'utente all'interno del proprio perimetro. Questa dinamica produce un’erosione dei clic che non ha precedenti nella storia del web e si traduce in un crollo verticale delle visite che, per molti editori, raggiunge la soglia del 90%. Si tratta di un’autopsia in tempo reale di intere redazioni e modelli di business. Quando un portale che trae linfa vitale dalla pubblicità, dalle affiliazioni o dai paywall vede evaporare quasi la totalità del proprio traffico, la conseguenza è l’estinzione quasi immediata o il drastico smantellamento del capitale umano. La brutalità di questo processo risiede in un controllo che molti operatori definiscono asfittico e coercitivo: l’illusione dell’opt-out, ovvero la possibilità teorica di negare l’accesso ai propri contenuti ai crawler (la capacità della macchina di catalogare i contenuti per renderli rintracciabili nei motori di ricerca) dell’intelligenza artificiale, si scontra con una realtà tecnica in cui il blocco dei bot dedicati all'AI non garantisce affatto l'esclusione dalle risposte generate, poiché queste ultime rimangono indissolubilmente legate all'indice della Search. Gli editori si trovano così stretti in una morsa biopolitica. Proteggere il proprio diritto d'autore significa rischiare l'oblio digitale, sparire dall'indicizzazione e, di fatto, smettere di esistere online. Questa ribellione degli editori, che si rifiutano di essere ridotti a materia prima gratuita per alimentare motori di calcolo altrui (nello specifico, non accettano di fungere da substrato estrattivo a costo zero per alimentare l'architettura di Gemini), prefigura uno scenario di desertificazione informativa, che investe direttamente la sicurezza e la stabilità delle nostre comunità. La scomparsa delle fonti originali è un problema che riguarda tutti, non solo gli addetti ai lavori, e una minaccia diretta alla salute democratica e alla sicurezza delle famiglie. Se i siti chiudono, ciò che resta è un feed di risposte orfane, un flusso di dati senza firme, senza controlli deontologici, senza possibilità di rettifica e privo di quel contesto critico che per ora solo il giornalismo umano serio e onesto può garantire. In questa situazione attuale, la disinformazione e le truffe trovano un terreno di coltura ideale, espandendosi proprio mentre il filtro della mediazione professionale si restringe. Il rischio di sicurezza diventa allora tangibile quando cerchiamo informazioni cruciali, che impattano sulle finanze o sulla salute. Affidarsi a una risposta sintetica senza verificarne l'origine e la datazione significa navigare senza bussola in un oceano di allucinazioni algoritmiche. La difesa contro questa deriva risiede in un'igiene digitale consapevole. È necessario tornare a interrogare le fonti, aprire almeno due o tre portali diversi per ogni notizia rilevante e cercare ostinatamente la data e gli autori originali di ogni dato. La risposta dell'AI, priva di contesto e di responsabilità, è lo strumento perfetto per indurre all'errore sistematico. Ciò che sta accadendo negli Stati Uniti è il primo atto di una riscrittura totale della biografia digitale umana, dove il rischio è sia esistenziale, sia economico. Se permettiamo che la memoria e l'informazione diventino un processo computazionale a senso unico, perderemo la capacità di distinguere la verità dalla sua simulazione sintetica.

La risposta delle autorità antitrust europee di fronte alla minaccia di una desertificazione informativa si configura come una vera e propria operazione di chirurgia legislativa, volta a preservare la biodiversità dell'ecosistema digitale continentale. Mentre negli Stati Uniti il crollo del traffico editoriale sotto i colpi delle AI Overviews appare come una conseguenza inesorabile di una deregolamentazione di fatto, l'Europa sta schierando un apparato normativo complesso, imperniato sulla convinzione che il pluralismo dell'informazione sia un bene pubblico primario, non sacrificabile sull'altare dell'efficienza algoritmica.

Il fulcro di questa difesa è rappresentato dal Digital Markets Act, che identifica le grandi piattaforme come "gatekeeper" (controllori dell'accesso), imponendo loro obblighi di trasparenza e di non-discriminazione, che mirano a impedire l'auto-preferenza dei servizi interni (come, appunto, le risposte generate dall'intelligenza artificiale) a discapito dei contenuti prodotti dalle fonti originali. L'approccio europeo mira a disinnescare la logica del controllo asfittico esercitata dai motori di ricerca, per cercare di garantire che il passaggio dall'indicizzazione alla sintesi operata dall'AI non si traduca in una sparizione forzata degli editori dal mercato dell'attenzione.

La Direttiva sul Diritto d'Autore nel Mercato Unico Digitale, con il celebre Articolo 15 sui diritti connessi per gli editori di giornali, fornisce lo strumento giuridico per evitare che l'informazione diventi materia prima gratuita per le macchine. Le autorità antitrust nazionali, con l'Autorité de la Concurrence francese in prima linea, hanno già iniziato a sanzionare le piattaforme che utilizzano i contenuti giornalistici per addestrare i propri modelli o per fornire risposte dirette senza negoziare un'equa remunerazione. Questa azione trasforma il rapporto di forza tra piattaforme e media. L'opt-out, oltre a essere una scelta tra il furto di dati e l'oblio digitale, deve soprattutto divenire l'inizio di una contrattazione economica obbligatoria, che riconosca il valore della fonte.

L'Europa sta inoltre perfezionando l'AI Act, il primo regolamento organico sull'intelligenza artificiale al mondo, che introduce requisiti stringenti di trasparenza sui dati di addestramento. Questo permette di mappare le "insorgenze" di contenuti protetti all'interno delle risposte sintetiche, rendendo visibile quel residuo irriducibile di paternità intellettuale che spesso le macchine tendono a occultare. L'obiettivo è prevenire la formazione di un feed di risposte privo di redazioni e di controlli deontologici, per garantire che ogni sintesi algoritmica porti con sé la traccia della fonte originale, così da proteggere la sicurezza delle famiglie e la salute del dibattito democratico.

In questa cornice, la lotta alla disinformazione e alle truffe è sostenuta dal mantenimento di un'infrastruttura di giornalismo umano forte e finanziariamente sostenibile. Le autorità europee scommettono sul fatto che, imponendo regole di ingaggio chiare e sanzionando l'abuso di posizione dominante, sia possibile trasformare l'intelligenza artificiale da predatore del traffico editoriale a strumento di supporto, preservando quella "memoria specchio" collettiva, che solo un panorama informativo pluralista può garantire. La resistenza del nostro continente a uno scenario di terra bruciata digitale dimostra che la sovranità tecnologica risiede, oltre che nello sviluppo di nuovi algoritmi, nella capacità politica di normare il limite oltre il quale la macchina smette di servire l'informazione per iniziare a divorarla.

La sanzione di 250 milioni di euro irrogata nel 2024 dall'Autorità della Concorrenza francese a Google ha segnato un punto di rottura fondamentale nella gestione tecnica dei flussi di dati destinati all'intelligenza artificiale, poiché colpisce direttamente l'opacità dei processi di addestramento del modello Gemini. Il fulcro del provvedimento risiede nella constatazione che Google ha utilizzato i contenuti di editori e agenzie di stampa per alimentare i propri algoritmi di apprendimento profondo senza una notifica preventiva e, soprattutto, senza garantire la neutralità dell'indicizzazione. Le autorità hanno evidenziato una criticità strutturale nel rapporto tra il motore di ricerca e l'intelligenza artificiale generativa.

Google ha mantenuto un'architettura in cui il rifiuto di concedere i dati per l'addestramento dei modelli LLM rischiava di compromettere la visibilità dei siti nella Search tradizionale, creando un vincolo di subordinazione, che svuotava di significato la libertà di scelta del detentore dei diritti. Questa commistione tra l'indice di ricerca e il database di addestramento è stata giudicata una violazione degli obblighi di trasparenza, in quanto impediva agli editori di distinguere tra la funzione di smistamento del traffico, vitale per la loro sopravvivenza economica, e lo sfruttamento del loro lavoro come materia prima per un prodotto concorrente. La sanzione affrontava inoltre la violazione degli impegni sulla remunerazione presi nel 2022 e sottolinea come Google non abbia fornito le informazioni necessarie per una valutazione equa del valore dei contenuti estratti, rendendo la negoziazione economica un processo unilaterale e asimmetrico. Questo intervento ha obbligato le Big Tech a una revisione della loro infrastruttura di crawling, imponendo la creazione di separazioni tecniche rigide, che permettessero di tracciare con precisione l'origine del dato e la sua finalità specifica.

L'intervento regolatorio francese del marzo 2024 ha agito come un elettroshock nel sistema nervoso del capitalismo estrattivo, imponendo per la prima volta una distinzione tecnica tra il diritto di essere indicizzati e il dovere di essere cannibalizzati. Questa separazione tra l'indice di ricerca e il database di addestramento è stata una vittoria di civiltà giuridica, poiché ha smascherato l'opacità con cui le Big Tech trasformavano il web in un substrato estrattivo a costo zero. Eppure, la storia del digitale insegna che ogni argine normativo genera nuove forme di erosione. Se è vero che la sanzione ha obbligato alla creazione di protocolli più trasparenti per la tutela del valore editoriale, è altrettanto vero che il potere computazionale non rimane mai inerte di fronte ai vincoli della legge. Resta dunque un interrogativo che scuote le fondamenta del nostro futuro informativo. Poiché Google e i giganti del silicio possiedono una capacità quasi biologica di generare vie alternative per perpetuare il proprio dominio sui mercati, cosa sta accadendo veramente nelle pieghe dell'architettura digitale ora che i riflettori delle sanzioni del 2024 sembrano essersi affievoliti? Il vincolo di subordinazione è stato realmente sciolto o stiamo assistendo alla nascita di una nuova e più sofisticata forma di assoggettamento algoritmico, dove la libertà di scelta del detentore dei diritti è solo l'ennesima variabile di un'equazione in cui il banco non perde mai?

In copertina, il simbolo del copyright ©AP ImagesEuropean Union.