L’occhio del padrone

Guidare un camion è un’attività molto complessa: richiede forza fisica, concentrazione mentale per lunghi periodi di tempo, destrezza nei movimenti, controllo delle proprie emozioni, capacità di cooperazione con altri camionisti, un’attività cognitiva continua, per evitare di fare incidenti o mantenere a lungo la stessa direzione di marcia. Eppure, quando si parla di professioni che implicano un lavoro cognitivo, ci si riferisce sempre ad altri tipi di lavori, come la designer, la programmatrice informatica, la manager di azienda…, tutte professioni diventate centrali con l’emergere della società dell’informazione e con la diffusione dei computer nei luoghi di lavoro, nelle istituzioni e nelle case private. Il camionista non è considerato un lavoro prettamente “cognitivo”. Eppure, gli attuali sistemi di intelligenza artificiale fanno ancora molta fatica ad automatizzare i complessi processi cognitivi che stanno alla base della guida umana di un camion. Lo sviluppo dell’intelligenza artificiale ha inavvertitamente dimostrato che lavori apparentemente poco qualificati come guidare un camion richiedono molta “intelligenza”, destrezza fisica e qualità emotive, e sono a tutti gli effetti dei lavori “cognitivi”. I veicoli a guida autonoma, infatti, dipendono dall'IA che impara via via ad imitare le decisioni intelligenti dei conducenti sulla strada. “Se, infatti, la capacità di guidare un veicolo può essere tradotta in un modello algoritmico è perché guidare è un’attività con una componente logica, – perché, in ultima analisi, all labour is logic”, (p. 3), tutte le attività lavorative per essere eseguite presuppongono operazioni mentali logiche, che possono essere misurate, calcolate e riprodotte da un sistema logico come una rete neurale.

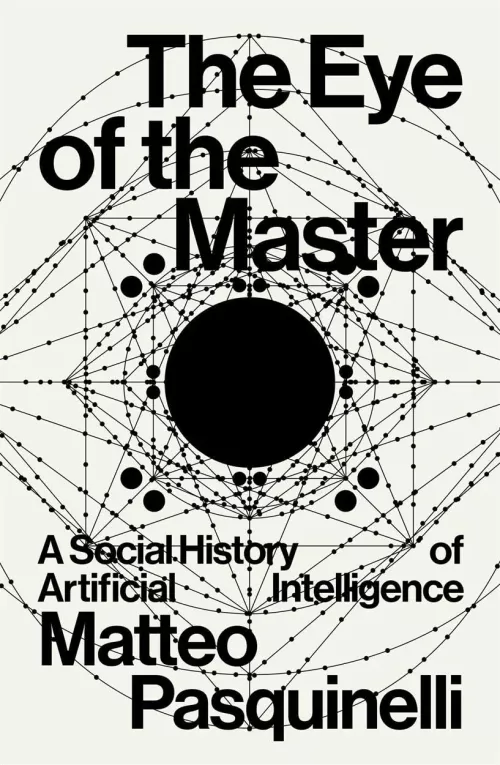

Questa è la constatazione da cui parte il bellissimo libro di Matteo Pasquinelli, The Eye of the Master, A Social History of Artificial Intelligence (Verso Books, 2023, di prossima traduzione italiana presso Carocci), per dimostrare come l'intelligenza artificiale sia una serie di tecnologie che emergono dal tentativo di “cattura” dell'intelligenza sociale incorporata nelle relazioni umane. L'essenza dell'IA, secondo Pasquinelli, non è replicare la cognizione umana, ma codificare e automatizzare le pratiche sociali e le relazioni di lavoro. La teoria di Pasquinelli, che chiama the labour theory of automation, sostiene che i sistemi di IA sono essenzialmente incarnazioni della conoscenza umana, delle competenze e della divisione del lavoro. Pasquinelli intende scrivere una genealogia sociale alternativa dell'IA, che fa emergere in primo piano la radice storica profondamente estrattivista (e colonialista) dell’IA. Uno degli aspetti più interessanti del libro è la capacità di riportare alla luce, come vecchi reperti perduti, le radici storiche dell’IA, connettendo la storia delle attuali IA ai primi tentativi di automatizzazione delle attività lavorative già nell'era industriale.

Quando si parla di automazione del lavoro si pensa sempre a quelle tecnologie che nel corso della storia industriale hanno via via meccanizzato alcune azioni umane ripetitive, mentre si sottovaluta il tentativo di meccanizzare il lavoro cognitivo umano. L’automazione del lavoro cognitivo umano incarnata dagli attuali sistemi di IA, secondo Pasquinelli, inizia non tanto con i primi esperimenti di creazione di sistemi intelligenti a metà del secolo scorso, ma ha origini ben più profonde, che collocherebbero la nascita di questi sistemi dentro le radici del colonialismo e del capitalismo industriale del diciannovesimo secolo.

Più in generale, potremmo dire che questo è un libro sulla trasformazione del lavoro dall’era industriale a quella cibernetica e su come il lavoro umano, sia manuale che cognitivo, sia stato al centro di un lungo processo di calcolo, misurazione e imitazione.

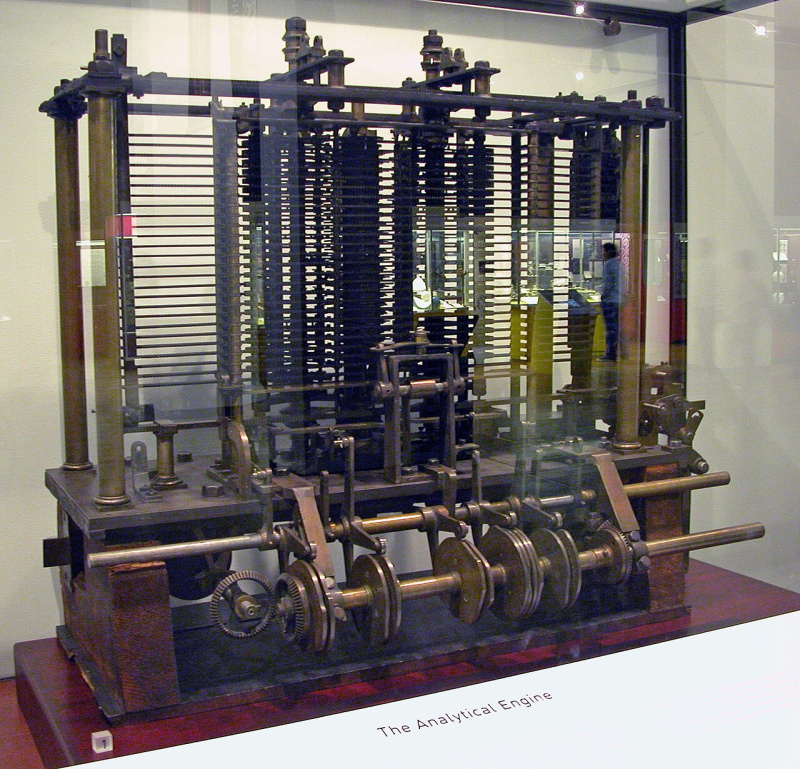

Nella prima parte del libro – the automation of mental labour during the industrial age – Pasquinelli compie una certosina ricostruzione storica degli esperimenti di Charles Babbage, noto a tutti come il padre dei computer moderni, nel tentativo di misurare il lavoro cognitivo umano e automatizzarlo.

La meccanizzazione del lavoro mentale umano aveva l’obiettivo di accelerare e migliorare quei calcoli a mano necessari per generare le tavole logaritmiche che stavano alla base del calcolo delle rotte marittime da parte delle navi mercantili dell’impero britannico. In un’epoca di aggressive espansioni coloniali da parte non solo dell’impero britannico, ma anche degli altri imperi coloniali europei, automatizzare questi calcoli e renderli più veloci, rappresentava un vantaggio enorme in termini economici. Le tavole logaritmiche, usate per calcolare la longitudine in mare aperto, erano altamente inaffidabili, a causa degli errori di calcolo umani, e questa inaffidabilità era la causa principale del naufragio di molte imbarcazioni mercantili e conseguenti perdite di carichi preziosi.

Fino a quel momento, i calcoli che producevano le tavole logaritmiche utili per la navigazione venivano fatti da una classe di lavoratori chiamati “computers” (calcolatori umani, appunto, ecco da dove viene il termine computer!), che ricoprivano il livello più basso di una struttura sociale piramidale, in cima alla quale c’erano i matematici, che formulavano i problemi da risolvere. Sotto di loro c’erano gli “algebristi” che dovevano scomporre i problemi matematici in dati e semplici operazioni di calcolo da dare in pasto alla classe di calcolatori umani, una vera e propria classe di operai “cognitivi” precarizzati – composti per lo più da studenti, donne e a volte da “parrucchiere disoccupate”.

Nell'Inghilterra dell'inizio del XIX secolo, i "computer" erano quindi lavoratori (per lo più donne) che eseguivano noiosi calcoli a mano. Babbage (insieme ad Ada Lovelace) mirava a meccanizzare questo lavoro mentale con macchine di calcolo alimentate a vapore, col fine di monitorare prima le prestazioni dei lavoratori e poi sostituirli con macchine meno recalcitranti.

Il lavoro di Babbage ha dato inizio alla meccanizzazione del lavoro mentale algoritmico e i suoi principi hanno plasmato il modo in cui la computazione è stata concepita in relazione all'industria, al lavoro e alla società.

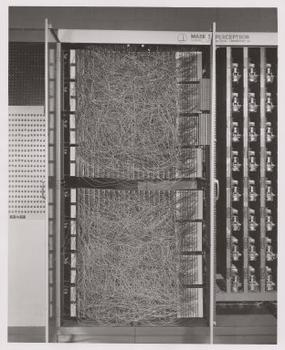

Nella seconda parte del libro l’autore passa ad analizzare la storia delle prime tecnologie di intelligenza artificiale a partire dal Perceptron (1943), tracciando in maniera convincente la linea che riconduce queste tecnologie alle origini meccaniche dell’automazione del lavoro cognitivo umano e alla lunga storia dei tentativi di sorveglianza dei lavoratori da parte dei datori di lavoro.

L’autore sostiene che questo tentativo di misurare, monitorare, ottimizzare e sostituire il lavoro cognitivo umano si è nel tempo evoluto per arrivare fino agli ultimi decenni con i sistemi di IA che imitano il comportamento umano collettivo, automatizzando essenzialmente l’intelligenza e la conoscenza di milioni di lavoratori in un’unica macchina.

Pasquinelli individua un filo nemmeno tanto sottile, che unisce la macchina analitica di Babbage e Lovelace a ChatGPT, attribuendo loro la stessa radice originaria e lo stesso obiettivo: automatizzare, meccanizzare quello che Marx nei Grundrisse chiamava “General intellect”, intelligenza collettiva e che poi nel Capitale avrebbe chiamato lavoratore collettivo, cioè una combinazione di competenza tecnologica e di intelligenza collettiva, o conoscenza sociale generale, prodotta dalle relazioni sociali che intercorrono tra i lavoratori. (Il libro è arricchito anche da una digressione molto interessante e originale, il capitolo 4, sulle origini del termine “general intellect” e sulla storia dei Grundrisse di Marx.)

Babbage voleva sostituire i calcolatori umani con una macchina più efficiente, ma per farlo doveva prima misurare ogni singola azione umana compiuta durante il calcolo dei logaritmi per poterla poi meccanizzare, così come ChatGPT sostituisce la generazione di linguaggio umano originale, ma per farlo deve prima aver studiato milioni di sequenze verbali prodotte dall’intelligenza collettiva umana (il general intellect marxiano) per poterne imitare la struttura sintattica.

In entrambi i casi, la conoscenza incarnata nei calcolatori umani dell’epoca di Babbage e negli utenti attuali di internet che hanno prodotto testi, viene “sussunta”, cioè digerita da una macchina senza alcuna compensazione, ma appropriata come in passato vennero estorte e privatizzate le terre comuni della campagna inglese che diedero inizio alla costruzione delle prime fabbriche industriali (le famose “enclosures”).

In sintesi, sia la macchina analitica di Babbage che ChatGPT provengono dallo stesso regime estrattivista, basato sull’estrazione unilaterale e forzata della conoscenza collettiva.

Infine, l’importante contributo di questo libro è quello di far vedere chiaramente come ogni innovazione tecnologica, IA compresa, non emerge in un vuoto, dalla mente di qualche inventore, ma è il frutto di un processo di “cristallizzazione” delle forze sociali produttive, cioè di un processo di imitazione, profilazione, monitoraggio, calcolo di conoscenze, competenze e relazioni di produzione insite negli attori sociali e trasformate da scienziati e imprenditori, lentamente, in un artefatto tecnologico, che però è prima di tutto un artefatto socio-tecnico, cioè una tecnologia che rinchiude dentro di sé conoscenze e attori sociali differenti, che hanno fornito, volontariamente o meno, i dati e i materiali grezzi per la messa a punto di quella tecnologia.

Alla fine è evidente che l’IA rappresenti il culmine di un lungo processo evolutivo iniziato con gli esperimenti di Charles Babbage e Ada Lovelace per quantificare il lavoro e automatizzarlo: “i modelli statistici del machine learning non sono poi, nei fatti, così radicalmente differenti dal design delle macchine di calcolo dell’era industriale, piuttosto sono omologhe: esse sono infatti costituite dallo stesso tipo di intelligenza analitica, orientata al calcolo e alla profilazione di azioni e comportamenti collettivi, anche se il machine learning compie questi calcoli in maniera molto più complessa (tenendo conto di un’enorme quantità di parametri)” (p. 247, traduzione mia).

Così, oggi, rispetto ai tempi di Babbage, “l’occhio del padrone”, che dà il titolo al libro, si è notevolmente espanso ed è diventato molto più invasivo e potente. I costi di addestramento di modelli come ChatGPT, la necessità di avere accesso a enormi quantità di dati e di possedere una infrastruttura globale di server per ospitare questi dati, hanno prodotto l’attuale condizione in cui poche aziende globali monopolizzano il mercato delle tecnologie IA. Il potere di queste aziende si espande, e si applica a contesti sempre più diversi e un tempo non sottoposti al calcolo e alla quantificazione su vasta scala, come ad esempio la sanità.

Al contrario di chi pensa che questi sistemi produrranno disoccupazione, Pasquinelli sostiene che l’obiettivo di queste tecnologie ormai non è più semplicemente sostituire il lavoro umano. Dopo averne studiato per due secoli la logica intrinseca, il suo funzionamento, i processi cognitivi alla base di esso, gli attuali sistemi di meccanizzazione del lavoro mentale non puntano a automatizzare le azioni di un singolo lavoratore, ma ad automatizzare la gestione, il management di migliaia di lavoratori. Ad essere automatizzato e sostituito in parte, è il lavoro dei “colletti bianchi”, dei manager, tramite il management algoritmico: “nella economia delle piattaforme, gli algoritmi rimpiazzano il management e moltiplicano il numero di lavori precari” (p. 250). I lavoratori sono necessari per produrre i dati e gestire la manutenzione della vorace infrastruttura dell’IA, ma il lavoro creato è spesso un “bullshit job”, come diceva Graeber, cioè un lavoro di merda come quello dei moderatori di contenuti di Facebook, costretti a guardare ore di materiale violento e pornografico ogni giorno, oppure come quello dei corrieri di Deliveroo, costretti a lavorare 12 ore al giorno sette giorni su sette, per mettere insieme uno stipendio appena decente, oppure il lavoro degli etichettatori di dati che filtrano le parole necessarie per l’addestramento di ChatGPT e sono appaltati come freelance pagati in bitcoin prevalentemente nei paesi del sud globale.

Il libro è un capolavoro, bisogna dirlo. Invece di leggere la miriade di saggi tutti uguali, scritti in pochi mesi da qualche filosofo apocalittico nei confronti della tecnologia (vedi Byung Chul Han), dovremmo tutti leggere saggi come questo, che rappresentano un modo profondo, documentato e rigoroso di esercizio del pensiero critico e della ricerca critica nel campo degli studi sociali delle tecnologie digitali. Questo libro è il frutto di almeno dieci anni di ricerca, è un esempio brillante di cosa significa davvero fare ricerca nelle scienze sociali, invece di scrivere libri di “opinione”.

Se c’è un limite che possiamo ascrivere al libro, è nelle conclusioni, dove ogni autore che compie una critica ad un dato sistema cerca sempre di accennare anche a delle possibili soluzioni.

Di fronte al monopolio del potere computazione esercitato da alcune aziende globali e di fronte a questo regime estrattivista e coloniale (vedi anche il libro di Nick Couldry e Mejias, di prossima uscita per Chicago University Press, Data Grab – the new colonialism of big tech and how to fight back), come si può non cadere nella disperazione, nel nichilismo fisheriano da realismo capitalista? Pasquinelli si chiede come sia possibile riprogettare monopoli su larga scala di dati e conoscenza (p. 251). La risposta che dà è ragionevole e condivisibile, ma anche estremamente utopica. Da un lato, ricorda il dibattito in corso sulla possibilità di progettare sistemi di IA pubblici o cooperativi, sottoposti a differenti regimi etici, ma giustamente sostiene che questo non basta. Sostiene che qualsiasi tecnologia “alternativa” deve essere inserita in un contesto di relazioni sociali diverso da quello attuale, in cui l’AI è il servizio di stati e multinazionali per rendere più efficienti i processi produttivi, ma non per aumentare il benessere generale degli abitanti della Terra (qui ricordiamo anche il saggio di Kate Crawford, Né intelligente né artificiale, che sostiene le stesse cose).

Pasquinelli scrive che la progettazione di qualsiasi tecnologia alternativa deve essere alimentata da una “cultura dell’invenzione, del progetto e della programmazione che si prenda cura e tenga conto dei bisogni collettivi e di tutte le comunità, e che non abbandoni la nostra agency e la nostra intelligenza all’automazione” (p. 252-53, traduzione mia). Ma come creare questa cultura? Come alimentarla? Pasquinelli sostiene che il primo passo di questa politica riguarda i processi di emancipazione e decolonizzazione e l’adozione di una mentalità tecnica differente, “una contro-intelligenza collettiva”, che miri a smontare, pezzo per pezzo, fino ad abolire, le attuali relazioni sociali e di potere sulle quali si fonda questo sistema socio-tecnico, quello che negli anni ’60 la New Left americana chiamava criticamente il “complesso accademico-militar-industriale” che stava dando luogo alla rivoluzione cibernetica. Il complesso militar-industriale criticato dagli studenti californiani è ancora qui, anzi, si è espanso ancora di più, però è anche vero che il movimento controculturale degli anni ’60 è riuscito a deviare la traiettoria di sviluppo dell’era dei computer, appropriandosi di essi per espandere la propria coscienza e costruire nuove comunità di interesse, come documentato dallo storico Fred Turner in From Counterculture to Cyberculture (2006). Ma quelle stesse controculture si sono poi trasformate nel brodo culturale che ha ridato nuova vita al vecchio complesso militar-industriale e generando le aziende tecnologiche globali di oggi. Sembra quindi che non ci sia speranza di abbattere, o ridimensione, la complessa infrastruttura socio-tecnica del capitalismo digitale, ma Pasquinelli fornisce alcuni esempi che dimostrano che c’è ancora spazio per resistere a questo potere, come i progetti di ricerca di Lilly Irani (il Turkopticon) che hanno dato vita a un vero e proprio movimento dei lavoratori della gig economy.

Per non finire travolti dal pessimismo, bisogna alimentare questa speranza e guardare a questi esempi. Nella vita quotidiana, come documentiamo anche Emiliano Treré ed io nel nostro libro, Algorithms of Resistance (MIT Press, 2024), esistono in realtà moltissimi esempi di resistenza al potere dell’IA, in ambiti molto diversi tra loro. Il futuro non è affatto già stato scritto.